先日の記事でAMD Ryzen AI Max+ 395搭載のGMKTec EVO X2とLM Studioを使用してLLMのベンチマークをしましたが、次はStable Diffusionを使用した画像生成についてもベンチマークをしていこうと思います。

実行環境は、Windows 11になります。

まずStable Diffusion WebUIを動かすための環境構築になります。(

※こちらの手順は、CPUでの実行でGPUでの生成ではないです。。。涙。。。

と言ってもこちらのサイトで手順が書いてありますのでそれに倣って進めて行くだけです。

まず、こちらのリンクからPython 3.10.6をダウンロードしてインストールします。(インストーラー時に)

インストールをしたらパスを通してコマンドプロンプトでpython –versionと入力してバージョンが表示されればOKです。

>python --version

Python 3.10.6次にこちらのサイトからgitをインストールします。

gitのインストールが完了したら、コマンドプロンプト開いて適当はディレクトリでをStable Diffusion WebUIをクローンします。

git clone https://github.com/lshqqytiger/stable-diffusion-webui-directml && cd stable-diffusion-webui-directml && git submodule init && git submodule updateクローンしたstable-diffusion-webui-directmlディレクトリ内の「webui-user.bat」ファイルをメモ帳などで以下のように修正します。

@echo off

set PYTHON=

set GIT=

set VENV_DIR=

set COMMANDLINE_ARGS=--skip-torch-cuda-test --no-half

call webui.batset COMMANDLINE_ARGS=の後に–skip-torch-cuda-test –no-halfを追加し保存ます。

※–no-halfは、「RuntimeError: Input type (float) and bias type (struct c10::Half) should be the same」のエラー対策のために付与

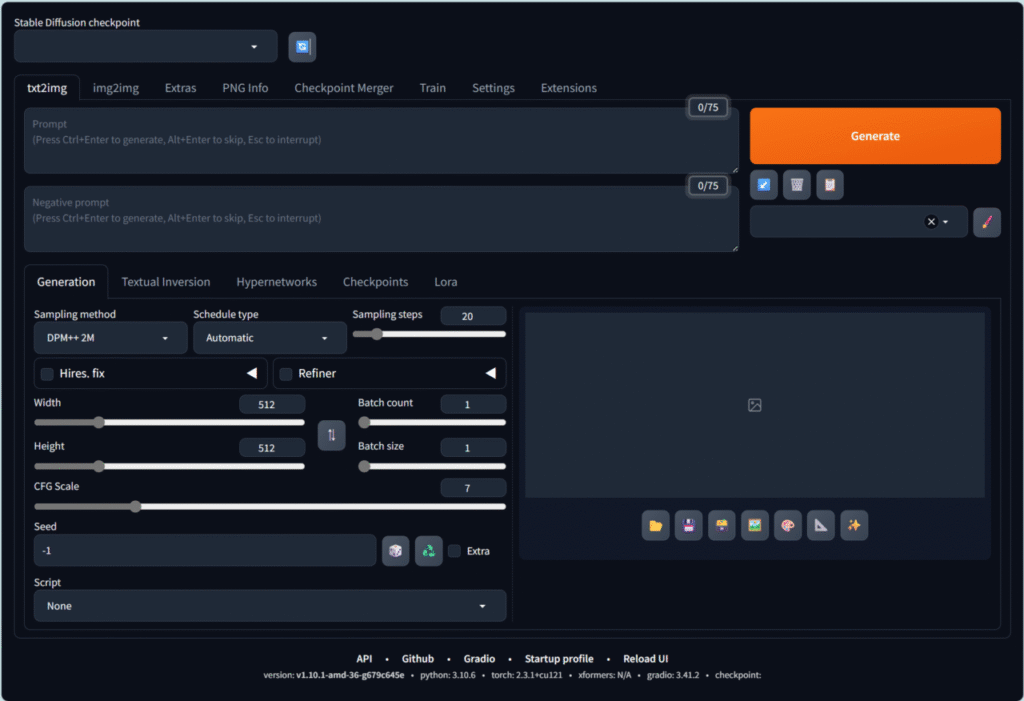

あとは、「webui-user.bat」をダブルクリックで実行すると必要なファイルのインストールが実行され、しばらくするとエラーが発生しなければ以下のページがブラウザで表示されます!(http://127.0.0.1:7860/)

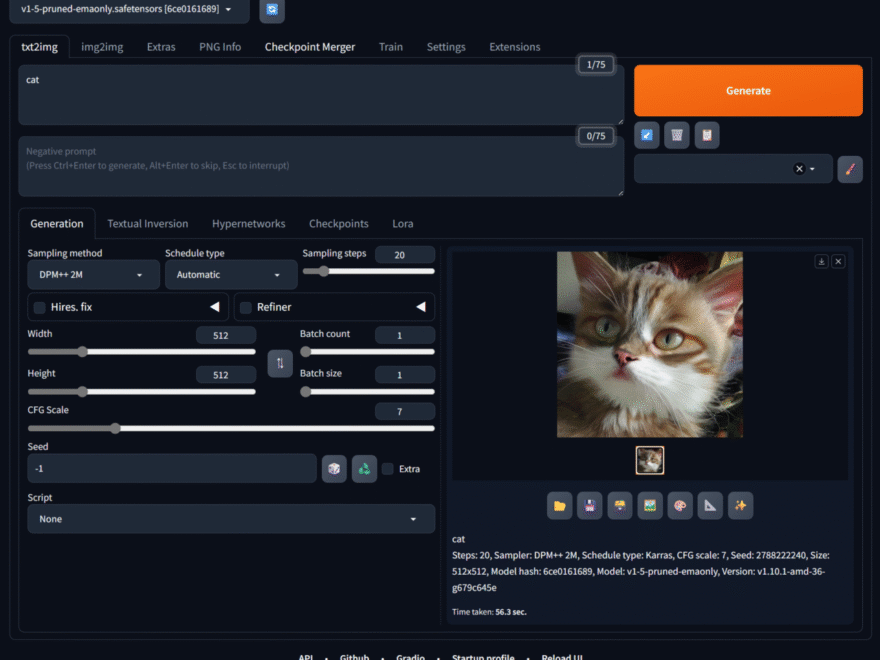

さてさて無事環境ができたっぽいので動作確認で画像を生成してみようと思います。

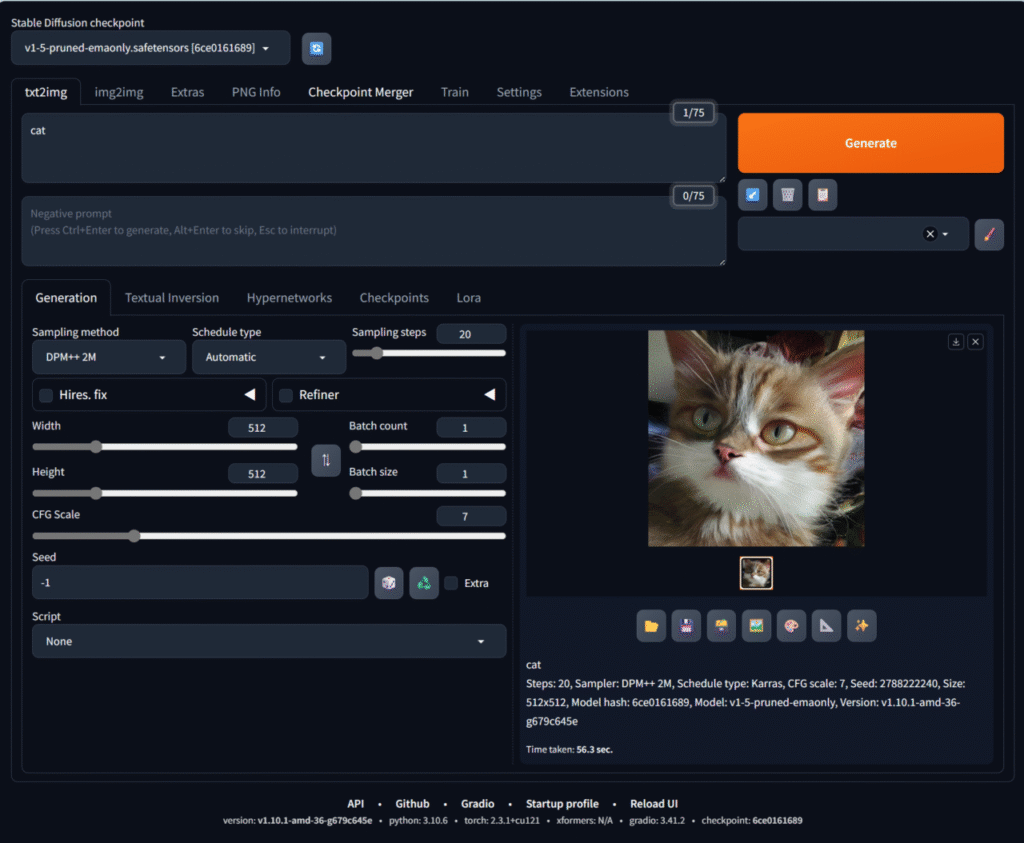

画面左上の「Stable Diffusion checkpoint」から最初からインストールされているモデルの「v1.5-pruned-emaonly.safetensors」を選択します。

あとは、プロンプトに「cat」と入力してGenerateしてみます。(それ以外の項目はデフォルトのままです。)

おぉぉぉ!猫の画像が生成されました!!

と思ってタスクマネージャーを見ていたのですが、CPUを使用してGPUは使われていませんでした。。。AMDの内臓GPUを使うために調査が必要です。。。